Zur Transkription des Reiseberichts von Franz Xaver Bronner nutzen wir die Plattform Transkribus. Neben anderen Funktionen bietet Transkribus auch die Möglichkeit zur automatisierten Texterkennung mithilfe von Deep Learning. Transkribus bietet hierzu bereits eine Vielzahl von vortrainierten Sprachmodellen an, zur Verbesserung der Ergebnisse ist es jedoch ratsam die tiefen neuronalen Netze auf eigenen Daten zu trainieren, um so ein Modell zu generieren, welches speziell für den eigenen Anwendungsfall – in unserem der Handschrift Bronners – optimiert ist. Im Folgenden werde ich mein Vorgehen beim Training des Sprachmodells beschreiben.

Auswahl der Daten

Als Trainingsdaten standen mir 250 händisch transkribierte Seiten aus Bronners „Reinschrift“ zur Verfügung.

Mein erster „systematischer“ Ansatz war es ein Modell auf allen verfügbaren Daten zu trainieren. Dies folgt der im Machine Learning verbreiteten Ansicht, dass mehr Daten auch immer besser seien. Das resultierende Modell wies jedoch deutlich schlechtere Evaluationsmetriken auf als ein Modell, welches ich zuvor auf 50 Seiten trainiert hatte.

In der Konsequenz habe ich mir die vorhandenen Trainingsdaten noch einmal genauer angeschaut und festgestellt, dass die Qualität der einzelnen Seiten teilweise sehr stark variiert, weshalb ich die Seiten anhand ihrer Textqualität einteilte. Als Maßstab für die Textqualität diente die Menge von Makeln im Fließtext wie Durchstreichungen, Ergänzungen zwischen den Zeilen und an den Rändern und sonstige Unleserlichkeiten. Anhand dieser Merkmale bildete ich fünf Kategorien für die Qualität der Seite: fehlerfrei (keines der genannten Makel), wenige Makel (<5), einige Makel (5-10), viele Makel (>10) und unbrauchbar, welche Seiten ohne handschriftlichen Text oder Transkription, fehlerhafte Dateien und Seiten mit außergewöhnlich vielen Makeln (nach subjektivem Ermessen) beschreibt. Außerdem habe ich für die Vergleichbarkeit der Modelle ein Evaluationsset von 13 Seiten der Kategorie „einige Makel“ erstellt – je nach Modell sind dies 5-12% der Größe des Trainingsdatensatzes.

Arbeitsdigitalisate der Handschrift von F.X. Bronner „Reise nach Kasan“ (Staatsarchiv Aargau, Signatur NL.A-0019-0009, hier Bl. 2 und 65).

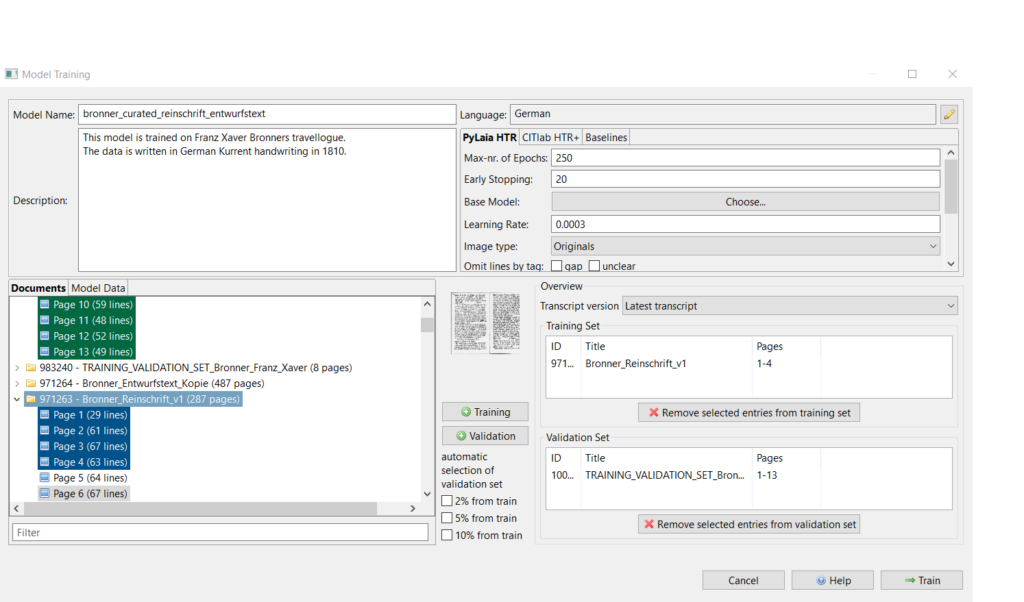

Screenshot erstellt von Jacob Möhrke (2022). CC BY-ND 2.0

Mit diesen Kategorien habe ich dann in verschiedenen Kombinationen Modelle trainiert. Die Kategorie „unbrauchbar“ wurde für alle Modelle ausgeschlossen. Das Modell, welches auf den Daten der Kategorien „fehlerfrei“, „wenige Makel“ und „einige Makel“ trainiert wurde, zeigte die besten Daten in der Evaluation (Character Error Rate (CER) 6% auf den Trainingsdaten und 5% auf den Validationsdaten).

Das bisherige Vorgehen fand ausschließlich auf dem Text der „Reinschrift“ statt. Es wäre allerdings erstrebenswert ein Modell zu haben, welches auf alle Texte Bronners, die uns zur Verfügung stehen, generalisierbar ist. Eine probeweise Anwendung des Modells auf dem „Entwurfstext“ zeigte keine befriedigenden Ergebnisse.

In der Hoffnung den Transfer auf den Entwurfstext zu verbessern habe ich das oben beschriebene Vorgehen auch auf die bereits transkribierten ca. 20 Seiten des Entwurfstextes angewendet und ein Modell auf den kombinierten Daten beider Texte trainiert. Die Evaluation zeigt: dieses Modell transferiert deutlich besser (CER von 6,4% auf den Trainingsdaten und 3% auf den Validationsdaten). Bis auf weiteres werden wir mit diesem Modell arbeiten, es ist jedoch davon auszugehen, dass es sich lohnen wird das Modell nachzutrainieren, nachdem weitere Transkripte als Trainingsdaten zur Verfügung stehen.

Screenshot erstellt von Jacob Möhrke (2022). CC BY-ND 2.0

Technische Parameter

Neben der Auswahl innerhalb der Trainingsdaten bietet Transkribus auch die Möglichkeit einige technische Parameter des Modells zu manipulieren und es so weiter zu optimieren. Hier gilt es eine Balance zwischen „overfitting“ (das Modell ist zu gut auf die Trainingsdaten trainiert und zeigt deshalb schlechte Ergebnisse auf neuen, bisher ungesehenen, Daten) und „underfitting“ (das Modell hat noch nicht alle Informationen aus den Trainingsdaten „gelernt“) zu finden. Außerdem kann man zwischen zwei verschiedenen Architekturen der Neuronalen Netze auswählen (bei Transkribus Engine genannt), namentlich PyLaia HTR und CITlab HTR+. Da hier eine Vielzahl an Variablen zusammen kommt, ist leicht ersichtlich, dass die Optimierung anhand dieser Paramterer sehr aufwändig werden kann.

Screenshot erstellt von Jacob Möhrke (2022). CC BY-ND 2.0

Mögliche Wege zur weiteren Verbesserung des Modells

Aus dem beschriebenen Vorgehen und den dabei gewonnenen Erkenntnissen ergeben sich für mich in erster Linie zwei Ansätze um das Modell weiter zu verbessern. Zum Einen durch eine feinere Granulierung der Kategorien, besonders der nach oben offenen Kategorie „viele Makel“. Zum Anderen durch weitere Experimente an den technischen Parametern des Modells.

Mögliche Erkenntnisse für ähnliche Projekte

Die Qualität der Trainingsdaten scheint eine relevante Rolle zu spielen und nach meiner Erfahrung scheint es sinnvoll zu sein, von einem Teil der verfügbaren Daten keinen Gebrauch zu machen, falls diese keine hinreichende Qualität aufweisen.

Außerdem sollte die Generalisierbarkeit der Modelle von vornherein mitgedacht werden. Die Erfahrung mit dem Transfer des Modells auf einen bisher ungesehenen Text deutet darauf hin, dass es wichtig wäre Trainingsdaten für alle Texte zu haben, welche später mit dem Modell transkripiert werden sollen.

0 Kommentare

Trackbacks/Pingbacks